2011/07/04

awk (1) 小技

先日参加した勉強会で awk (1) 関連の発表があったので、 ちょっとした小技を紹介してみる。

- system() を利用する際の注意

-

awk の中で外部コマンドを実行する場合は

組み込み関数 system() が利用できるが、

この関数を利用して外部コマンドを実行すると

入出力 stream がオープンされるので、

ファイルディスクリプタが消費されてしまう。

従って awk 内で何度も system() を実行すると、 オープンできるディスクリプタの上限を超過してしまい、 awk の実行が中断されてしまう可能性がある。

その場合 close() を利用して system() がオープンした stream を閉じれば良いのだが、 awk の system() では stream を明示的に扱わない。 そこで system() で実行したコマンドを close() の引数で指定する事で stream を閉じる事ができる。1awk '{ 2 : 3 # コマンドを生成 4 command = sprintf("%s %s %s", command, arg1, arg2); 5 # コマンドを実行して結果を取得 6 buf = system(command); 7 # stream をclose 8 close(command); 9 : 10}'

- 関数内ローカルな変数の使用

-

nawk は function を利用する事で

内部関数を作成する事ができるが、

関数内でローカルな変数を明示的に定義する事ができない。

そこで関数宣言の仮引数部に変数を定義する事で、

関数内ローカルの変数として利用できる。

1awk '{ 2 : 3 # 関数 foo の定義 4 # num: ループ数 5 # 以下ローカル変数 6 # i: ループウンタ 7 function foo(num, i) 8 { 9 # i はローカル変数扱いなので呼出元の i は影響を受けない 10 for(i=0; i<1num; i++) 11 : 12 } 13 : 14 foo(num); 15 : 16 }'

但し関数呼び出し時と関数定義時に引数の数が等しくないので、 後に混乱しないためにコメントで明記するなどの処置は必要。

2011/07/01

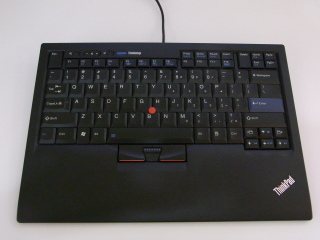

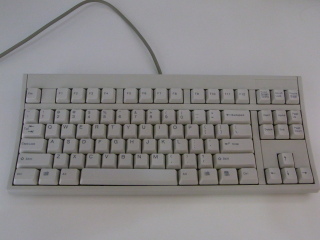

Keyboards

現在職場で愛用中のキーボード達。

改めて見ると個人所有のキーボードが沢山あって驚いた。

- PFU Happy Hacking Keyboard PD-KB02

-

PFU Happy Hacking Keyboard PD-KB02Happy Hacking Keyboard としては2代目の製品かな? いちばん古くから愛用しているキーボード。

メンプレンスイッチのキータッチと シリンドリカル・カーブドスカルプチャの構成は 今でもいちばん気に入っていて、 FreeBSD 端末に接続されている。 プログラムを書くときは、このキーボードと FreeBSD と vi が必須。 - PFU Happy Hacking Keyboard Professional 2 PD-KB400WN

-

PFU Happy Hacking Keyboard Professional 2 PD-KB400WNUSB 接続タイプの新世代 Happy Hacking Keyboard。

静電容量無接点方式で押下圧が 45g なので、 キータッチは PD-KB02 に比べると若干軽く感じるが、 打鍵音が若干「カチャカチャ」気味なのが気になる。 シリンドリカル・ステップスカルプチャなので、 手を自然に置いた時の感じが PD-KB02 とは若干異なり 微妙な違和感を感じる。

- Apple Wireless Keyboard MB167LL/A

-

Apple Wireless Keyboard MB167LL/A薄型 Bluetooth 接続の Apple Wireless Keyboard で、 AA セルを 3 本利用する初代タイプ。

酸化皮膜処理のアルミニウムボディは非常に美しいのだが、 パンタグラフタイプなのでキータッチが軽すぎ、 しかもストロークが短いので打鍵感が頼りなく感じてしまい、 キー入力時に底打ちしてしまうのが微妙に使いづらい感じ。 以前は 27インチの iMac のメインキーボードとして活躍してた。 現在は自宅の TV に接続されている Mac MINI のキーボード。 - Lenovo ThinkPad USB TrackPoint Keyboard 55Y9003

-

Lenovo ThinkPad USB TrackPoint Keyboard 55Y9003かつての IBM Space Saver Keyboard の流れをくむ トラックポイントが搭載された薄型のキーボード。

こちらもパンタグラフタイプなのでキータッチが軽く、 ストロークも短めなので本家 IBM Space Saver Keyboard ほどは打鍵感が良くない。 - Apple USB Keyboard

-

Apple USB KeyboardUSB 接続の Apple 社純正フルキーボード。

メンプレンスイッチの打鍵感は素晴らしく、 シリンドリカル・カーブドスカルプチャなので違和感を感じない。

テンキーが付いているフルキーボードは邪魔なのだが、 Macintosh 独特の特殊キー(コマンドキー)をクリックしながら 電源をオンにするといった特殊な用途のために USB 接続の純正キーボードが必要な場合がまれにあるので 手元に置いてある。 - Fujitsu FKB8745-T101

-

Fujitsu FKB8745-T101一部では割と有名な富士通高見澤製のキーボード。

メンプレンスイッチのキータッチと シリンドリカル・カーブドスカルプチャというのは PD-KB02 と同じ構成だ。

そもそも PD-KB02 も富士通高見澤製なので 打鍵感なども殆ど変わらない。 PD-KB02 にファンクションキーと カーソルキーを付けた様なものだと思う。

Windows マシンを操作する場合はカーソルキーやファンクションキーが あった方が楽なので手元に置いてあったのだが、 今は手元に Windows マシンがなくなってしまったので、 サーバルームのコンソール用に利用している (良いキーボードなので若干勿体ないな)。 - PFU Happy Hacking Keyboard Type-S PD-KB400WNS

-

PFU Happy Hacking Keyboard Type-S PD-KB400WNS前述の Happy Hacking Keyboard Professional の進化版。

従来のモデルに比較するとキータッチが格段に良くなっている。 カチャカチャ音が完全に消されていて 静かで心地よい音になっているので、 静かなオフィスでも気にせずにタイピングに集中できるし 何よりも打鍵音に安っぽさがなくなって非常に良い感じ。

しかも各キーの軸が安定していてブレる感じがないので キー入力時に全く不快感を感じなくなった。Type-S という名称だけど全然別モノな感じでとても良い。 現在は iMac に接続されているが、 今の所 PD-KB02 と同じ位気に入った。

問題は高価な事かな。

2011/06/15

php の proc_open() を利用した openssl コマンドの実行

php ネタ

openssl (1) で暗号化されたファイルを復号化する処理を

php で実装する必要があった。

pear を探せばその手のモジュールは多分あるだろうと思ったが、

標準で含まれないモジュールに依存したくなかったので

外部コマンドの openssl を利用する方法を試してみた。

php では入力、もしくは出力のみの外部コマンド実行は

popen() を利用できるが、

入出力双方向が必要なので proc_open() を利用する。

最初は proc_open() した openssl の入力側パイプに

暗号化されたデータを全て出力 (fwrite()) した後で

出力側パイプから復号化されたデータを読み出し

(fread()) ていたのだが、

入力データがある程度のサイズを越えると

openssl はデータ読込みの途中でデータを出力しないと

読込み (もしくは処理) をブロックしてしまう様なので、

fwrite() の後に fread() を実行する様に修正した。

この時、当初は stream_select() を利用してパイプの出力側からの

入力可否を監視する様にしたのだが、

stream_set_bloking() を利用してパイプの出力側を

非ブロックモードにする事で、

パイプから読込めない場合でも fread() が即リターンするので

stream_select() の呼出しによりコードが煩雑になる事が避けられた。

1<?php 2 /* 3 * Copyright (c) 2011 Mitzyuki IMAIZUMI. All rights reserved. 4 * 5 * $Id: decrypt.php 3 2011-06-16 16:15:48Z mitz $ 6 */ 7 8 define("OPENSSL", "openssl enc -d -des3 -pass pass:%s"); 9 define("BLOCSIZE", "4096"); 10 11 /* 12 * ファイルの復号化 13 * $1: ファイル名 14 * $2: サイズ 15 * $3: パスフレーズ 16 */ 17 function decrypt($file, $size, $pass) 18 { 19 20 $desc = array( 21 0 => array("pipe", "r"), /* stdin: pipe */ 22 1 => array("pipe", "w"), /* stdout: pipe */ 23 2 => array("file", "/dev/null", "w") /* stderr: /dev/null */ 24 ); 25 26 if(($fp = fopen($file, "r+"))){ 27 if($data = fread($fp, $size)){ 28 if(preg_match("/^Salted_/", $data)){ 29 /* 暗号化されている場合 */ 30 if($pp = proc_open(sprintf(OPENSSL, $pass), $desc, $pipe)){ 31 /* 32 * `openssl enc -d …' を実行する。 33 * 34 * ファイルの内容はすでに $data に格納されているので 35 * BLOCSIZE 単位で openssl の標準入力に出力する。 36 */ 37 38 stream_set_write_buffer($pipe[0], 0); 39 stream_set_blocking($pipe[1], 0); 40 41 $buf = ""; 42 43 while($size > 0){ 44 /* 45 * 1 ブロック出力 46 * substr() は開始位置に負の値を指定すると 47 * 文字列の終端を起点とした開始位置からの 48 * 部分文字列が取得できる。 49 */ 50 fwrite($pipe[0], substr($data, 0 - $size, BLOCSIZE)); 51 $size -= BLOCSIZE; 52 /* 53 * openssl からの読み出し処理 54 * 非ブロッキングなので、 55 * 読めない場合は即座に fread() から戻る。 56 * 57 $buf .= fread($pipe[1], BLOCSIZE); 58 } 59 fclose($pipe[0]); 60 61 while(!feof($pipe[1])) 62 $buf .= fread($pipe[1], BLOCSIZE); 63 fclose($pipe[1]); 64 65 proc_close($pp); 66 } 67 /* 68 * 復号化したデータの出力 69 * 入力ファイルを書き換える 70 */ 71 fseek($fp, 0); 72 ftruncate($fp, 0); 73 fwrite($fp, $buf); 74 } 75 } 76 /* 暗号化されていない場合はそのまま close() する */ 77 fclose($fp); 78 } 79 80 } 81 82?>

2011/06/16 追記

ブロック転送のロジックを整理して最適化した。データサイズ $size をループの制御変数とする事で 余計な変数や転送ブロック数の計算を削除し、 openssl への出力データの部分文字列切り出し処理で substr() を利用する際に負の値を指定して 開始位置を文字列後端からの位置で指定する様に変更した。

2011/05/24

シェル変数への情報セット

例えば wget (1) コマンドへ proxy サーバの情報を伝えるためには http_proxy シェル変数に URL を http://[ID[:pass@]]FQDN[:port] 形式でセットする必要があるが、 proxy 情報が以下の形式でファイル格納されていれば 1 行で簡単にシェル変数に設定できる。

proxy.example.com # プロキシサーバの FQDN 8080 # プロキシサーバのポート番号 user # プロキシサーバの認証 ID passwd # プロキシサーバの認証パスワード

1#!/bin/sh 2 3setproxy() 4{ 5 6 local _var 7 8 _var=${1} 9 10 if [ -f ${2} ] 11 then 12 set -- `sed 's/#.*//g' ${2}` 13 test -n "${1}" && eval "${_var}=\${1:+http_proxy=http://\${3:+\$3\${4:+:\${4}}@}\${1}\${2:+:\${2}}}" 14 fi 15 16} 17 18setproxy http_proxy ファイル名 19sh -c "${http_proxy} wget …" 20 :

2011/05/13

ディスク容量のチェックツール

随分と時間が開いてしまったが、友人の awk (1) の勉強支援の第 4 段。 ディスクの容量をチェックして警告メイルを送信するためのスクリプト。

df (1) の内容を簡単に解析して、

ルートパーティションの使用率が指定した値以上の場合は警告メイルを送信し

logger (1) を利用して syslog にも警告を出力する。

1#!/bin/sh 2# 3# All rights reserved, copyright (c) 2011, Mitzyuki IMAIZUMI 4# $Id: rdf,v 1.1 2011/05/13 17:38:09 mitz Exp $ 5# 6 7myname=${0##*/} 8tmpfile=${TMP:-/tmp}/${myname}.$$ 9logger=/usr/bin/logger 10df="LANG=C df -h" 11 12# 警告メイルの宛先 13to=root@example.com 14 15# 警告処理 16warning() 17{ 18 19 LANG=C 20 subject="##### [ ${1}: Disk Usage ] #####" 21 ${logger} "${subject}" 22 cat << EOF | mail ${to} -s "${subject}" 23 24${1} 25 26`date` 27 28`cat ${2}` 29EOF 30 31} 32 33# 終了時に一時ファイルを削除 34trap 'rm -r ${tmpfile}; exit' 0 1 2 3 9 13 15 35 36# メイン処理 37 38# tee(1) を使って df(1) の出力を awk(1) と一時ファイルの両方に出力 39${df} | tee ${tmpfile} | 40 awk '{ 41 # 最後のフィールドが '/' の場合 (ルートパーティション) 42 if($NF == "/") 43 # 最後の直前のフィールドが使用率なので閾値との比較結果をリターン 44 exit($(NF-1) < '${1:-70}') 45 }' && warning `hostname` ${tmpfile}

2011/02/28

重複メイル削除ツール

友人の awk (1) の勉強支援の第 3 段。

以前 Software

のペイジで公開したスクリプトの中身。

1 メール 1 ファイルの形式(mh 形式)で格納されたメイル本文のうち

Message-Id: ヘッダが重複するものを抽出して削除するツールで、

sort (1) や uniq (1) だけを利用しても実装可能だが、

可読性と拡張性、実装の手間等を考えて簡単に awk (1) で実装した。

Message-Id: ヘッダから取得したメッセージ ID をインデックスとして

ファイル名を連想配列に格納しており、

既にメッセージ ID が連想配列のインデックスとして存在している場合は

メッセージ ID が重複したものとしてファイル名を標準出力に出力するだけの

非常に簡単な内容のスクリプトだ。

1#!/bin/sh 2# 3# All rights reserved, copyright (c) 2009, Mitzyuki IMAIZUMI 4# $Id: DupmailMac,v 1.1 2009/09/30 09:25:09 mitz Exp $ 5# 6 7exec 2> /dev/null 8 9# Mac のメールボックスのデフォルトロケーション 10basedir="${HOME}/Library/Mail" 11 12find ${basedir} -name "*.mbox" -a -type d | 13while read folder 14do 15 if [ -d "${folder}/Messages" ] 16 then 17 awk '{ 18 # 大文字小文字を区別しないために全部小文字に変換 19 if(tolower($1) ~ /^message-id:/){ 20 # 入力行を `:' で分割する (line[2]: message-id) 21 split($0, line, ":"); 22 # message-id から余計なスペース、 <、> を削除 23 gsub("[<> ]", "", line[2]); 24 25 if(message[line[2]] != "") 26 # message-id に対応するファイルがある場合はファイル名を表示 27 print FILENAME; 28 else 29 # message-id に対応するファイルがない場合はファイル名を格納 30 message[line[2]] = FILENAME; 31 } 32 }' ${folder}/Messages/* | 33 # ファイルの削除 34 sort | uniq | xargs rm 35 fi 36done

2011/02/25

awk を利用した構文解析ツール

友人の awk (1) の勉強支援の第 2 段。

今回はちょっと複雑な処理なので追うのが大変かも?

このスクリプトは随分以前(1996年頃)に作成したのだが、

プログラムによって微妙に異る複数の設定ファイルの中身を

解析するために作成したそこそこ汎用の構文解析機だ。

本来は perl (1) などで記述したかったのだが、

よんどころない事情で awk (1) により実装した。

以下に示す構造の状態遷移テーブルで状態(status)とキーワード(token)を定義し、

それぞれの status の時に出現する入力データ中の token により

定義されていてば外部コマンドを実行して次の status への遷移を繰り返す。

状態遷移デーブルは 1カラム目が '#' の行、タブ、

スペースのみの行は無視する。

`%syntax' で始まる行が token の定義となり、

次の行以降が status の時に出現する token 毎の定義で、

実行するコマンドと遷移する status、

もしくはシンタックスエラー(error)を記述する。

予約された状態値として初期状態を示す `start'と

エラー状態を示す `error' が定義されており、

エラー状態では標準エラー出力にメッセージを出力後終了する。

オプションとして開始時に 1 度だけ実行される初期処理コマンドを

`%start' で始まる行に、

終了時に 1 度だけ実行される終了処理コマンドを

`%end' で始まる行にそれぞれ定義できる。

%syntax token1 token2 ... * start status1:command1 error ... status2 status1 status3:command3 error ... statusN:commandN

: statusN error error ... start %start command parm .... %end command parm ....

status 定義行ではその status に遷移した際に実行するコマンドを `:' に続けて記述でき、 コマンドの引数には以下の特殊文字が指定できる。 全ての特殊文字の置き換えを終了するとシェルを通してコマンドを実行する。

- %

- 現在のトークンに置き換えられる

- ,

- スペースに置換えられる

- $0

- 直前のコマンドのリターン値に置き換えられる

- $1 〜 $N

- このコマンドの第 3 引数以降に置き換えられる

実際に使用した状態遷移テーブルの例を示す。 下で示す形式の設定ファイルの解析を実施するためのもので、 開始状態から入力データに応じて状態値を遷移させながら解析処理を実施する。

# 最初に実行されるコマンド

%start ${path}/do.start

# 最後に実行されるコマンド

%end ${path}/do.end $0

# token 定義

%syntax { } , = *

# 状態遷移テーブル

start error error error error name:${path}/do.name,%,$0,$1,$2

name keyword error error error error

keyword error start error error continue:${path}do.keyword,%,$0,$1,$2

continue error error error equal error

equal error error error error next:${path}/do.val,%,$0,$1,$2

next error start keyword error error

解析させた設定ファイルの形式。

名称1 {

キーワード1 = 値1,

キーワード2 = 値2,

:

キーワードN = 値N

}

:

名称M {

キーワード1 = 値1,

キーワード2 = 値2,

:

キーワードN = 値N

}

この定義ファイルの解析を実行すると

以下の順にコマンドを実行する事と等価な処理が実施できる。$ ${path}/do.start $ ${path}/do.name 名称1 $? 引数1 引数2 $ ${path}/do.keyword キーワード1 $? 引数1 引数2 $ ${path}/do.val 値1 $? 引数1 引数2 $ ${path}/do.keyword キーワード2 $? 引数1 引数2 $ ${path}/do.val 値2 $? 引数1 引数2 : $ ${path}/do.keyword キーワードN $? 引数1 引数2 $ ${path}/do.val 値N $? 引数1 引数2 : $ ${path}/do.name 名称M $? 引数1 引数2 $ ${path}/do.keyword キーワード1 $? 引数1 引数2 $ ${path}/do.val 値1 $? 引数1 引数2 $ ${path}/do.keyword キーワード2 $? 引数1 引数2 $ ${path}/do.val 値2 $? 引数1 引数2 : $ ${path}/do.keyword キーワードN $? 引数1 引数2 $ ${path}/do.val 値N $? 引数1 引数2 $ ${path}/do.end $?

そしてスクリプト本体。 今見返すと冗長な記述などもあるが敢えてそのままにしておく。

1#!/bin/sh 2# 3# Copyright (c) 1996 Mitzyuki IMAIZUMI, All rights reserved. 4# 5# $Id: parser,v 1.7 1996/02/01 19:33:18 mitz Exp $ 6# 7# 名称 8# parser - 状態遷移テーブルに基づいてシンタックスをチェック 9# 10# 構文 11# parser config input [引数…] 12# 13# 引数 14# config 15# 状態遷移テーブル 16# input 17# 入力ファイル 18# 引数… 19# 各状態で実行するコマンドの引数 20# 21 22# パラメタチェック 23test $# -lt 2 -o ! -f $1 -o ! -f $2 && exit 255 24 25trap '' 1 2 3 5 9 13 15 26 27conf=${1}; file=${2}; shift 2 28 29for i 30do 31 parm="${parm},${i}" 32 shift 33done 34 35# %syntax 行から token を取得(最後の token は除外 36token=` 37 awk '{ 38 if($1 == "%syntax"){ 39 for(i=2; i<NF; i++) 40 printf("%s", $i); 41 exit 42 } 43 }' ${conf}` 44 45# 入力ファイルの token 前後にスペースを付加する 46sed 's/['${token}']/ & /g' ${file} | 47 48awk ' 49 # 50 # 初期処理 51 # 状態遷移テーブルのリード 52 # 53 BEGIN{ 54 55 argc = split("'${parm}'", argv, ","); # 引数を格納 56 argv[1] = 0; 57 58 while(getline < "'${conf}'" > 0){ 59 if(/^#/ || /^[ \t]*$/) # コメント行/空行 60 continue; 61 if($1 == "%start"){ # 初期処理定義行 62 $1 = ""; 63 prolog = $0; 64 } 65 else if($1 == "%end"){ # 終了処理定義行 66 $1 = ""; 67 epilog = $0; 68 } 69 else if($1 == "%syntax") # トークン定義行 70 for(i=2; i<NF; i++) 71 item[i-1] = $i; 72 else # 状態遷移定義行 73 for(i=2; i<NF; i++) 74 if(p = index($i, ":")){ 75 data[$1 item[i-1]] = substr($i, 0, p-1); 76 command[$1 item[i-1]] = substr($i, p+1); 77 } 78 else 79 data[$1 item[i-1]] = $i; 80 } 81 if(prolog != "") 82 argv[1] = exec(prolog, ""); 83 84 status = "start"; 85 86 } 87 88 # 89 # トークンチェック 90 # 91 function isitem(item, token, i) 92 { 93 94 for(i in item) 95 if(item[i] == token) 96 return 1; 97 98 return 0; 99 100 } 101 102 # 103 # コマンド実行 104 # 105 function exec(command, token, buf, i) 106 { 107 108 gsub("%", token, command); 109 for(i=0; i<argc; i++){ 110 buf = sprintf("\\$%d", i); 111 gsub(buf, argv[i+1], command); 112 } 113 gsub(/,/, " ", command); 114 115 i = system(command); 116 close(command); 117 118 return i; 119 120 } 121 122 # 123 # メイン処理 124 # 125 { 126 127 # コメント行スキップ 128 if(/^#/) 129 continue 130 131 for(i=1; i<NF; i++){ 132 if(isitem(item, $i)){ 133 format = command[status $i] 134 status = data[status $i] 135 } 136 else{ 137 format = command[status] 138 status = data[status] 139 } 140 if(status == "error"){ 141 printf("%s: %d: syntax error \"%s\"\n", 142 "'${file}'", NR, $i) | "'cat' >2" 143 ret = 255 144 exit 145 } 146 else if(format != "") 147 if(format == "exit"){ 148 ret = argv[1] 149 exit 150 } 151 else 152 argv[1] = exec(format, $i) 153 } 154 155 } 156 157 # 158 # 終了処理 159 # 160 END{ 161 if(epilog != "") 162 exec(epilog, "") 163 164 exit ret 165 } 166'

2011/02/24

awk スクリプト

知り合いが awk (1) の勉強をしたいと言ってるので、

支援がてら過去に作成したスクリプトをさらしてみる。

このスクリプトは linux 上で稼働している

あるプログラムが取得した共有メモリの残骸を掃除するスクリプトで、

ipcs (8) で取得した共有メモリ一覧のうち、

3 件連続しているキーが存在する場合 ipcrm (8) をコールして

共有メモリを削除する処理を行う。

短いスクリプトながら、外部コマンドの呼出し (system())、

コマンドからの値取得 (getline())、

そして関数内ローカルスコープの変数定義など

awk (1)の持っている機能を結構活用しているので、

多少なりとも参考にして貰えるとうれしい。

1#!/bin/sh 2# 3# Copyright (c) 2010 Mitzyuki IMAIZUMI, All rights reserved. 4# 5# $Id: shmrm,v 1.7 2010/05/08 09:03:15 mitz Exp $ 6# 7# 共有メモリ削除処理 8# 9 10LANG=C /usr/bin/ipcs -m | sort | 11 12awk ' 13 # 14 # 初期処理 15 # 16 BEGIN{ 17 18 max = 0; # 削除対象キーインデックス 19 num = 0; # 削除対象共有メモリインデックス 20 ipcrm = "/usr/bin/ipcrm"; # ipcrm コマンド 21 22 } 23 24 # 25 # 16進数 -> 10進数変換 26 # cmd, dec はローカル変数として利用するために仮引数宣言とする 27 # 28 function h2d(hex, cmd, dec) 29 { 30 31 # printf(1) を利用して 16進数を 10進数に変換 32 cmd = sprintf("printf '%%d' %s", hex); 33 # printf(1) の実行結果を getline で変数 dec に取得 34 cmd | getline dec; 35 close(cmd); 36 37 return dec; 38 39 } 40 41 # 42 # 3連続するキーかのチェック 43 # start, i はローカル変数として利用するために仮引数宣言とする 44 # 45 function cont3(num, start, i) 46 { 47 48 start = h2d(key[num]); 49 50 for(i=1; i<3; i++) 51 if(h2d(key[num+i]) != start + i) 52 return 0; 53 54 return 1; 55 56 } 57 58 # 59 # コマンド実行 60 # 61 function exec(key, arg) 62 { 63 64 system(sprintf("%s -%s %s", ipcrm, arg, key)); 65 66 } 67 68 # 69 # 共用メモリ/セマフォの削除 70 # 71 function shmrm(key, num) 72 { 73 74 # 共有メモリを削除 75 exec(key, "M"); 76 77 # セマフォを削除 78 if(num % 3 == 2) 79 exec(key, "S"); 80 81 } 82 83 # 84 # メイン処理 85 # 86 { 87 88 # owner が root で権限が 666 かつ nattch が 0 の共用メモリを検索 89 if($3 == "root" && $4 == "666" && $6 == 0) 90 key[max++] = $1; 91 92 } 93 94 # 95 # 終了処理(ある意味こっちがメイン) 96 # 97 END{ 98 99 if("'$1'" == "-f"){ 100 # 強制モード -- 3連続していないキーでも削除 101 for(n in key) 102 shmrm(key[n], 2); 103 } 104 else { 105 # 通常モード -- 3連続しているキーが削除対象なので抽出する 106 for(i=0; i<max; i++) 107 if(cont3(i)) 108 for(j=0; j<3; j++) 109 target[num++] = key[i+j]; 110 111 # 削除対象の共有メモリ/セマフォを削除 112 for(n in target) 113 shmrm(target[n], n); 114 } 115 116 } 117'

2011/02/17

ssh

ssh (1) コマンドは接続先のホスト情報をローカルに保存していて、 接続するたびに接続先が正しいホストかを確認する機能を持っている。 これはホスト名の詐称や DNS poisoning などにより 正しくない接続先に接続してしまうという事態を防止するためには 非常に便利で有用な機能ではあるが、 接続先のシステムが再インストールなどでホスト情報が変更になってしまった場合、 ssh で接続しようとすると

$ ssh ホスト名 @@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@ @ WARNING: REMOTE HOST IDENTIFICATION HAS CHANGED! @ @@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@ IT IS POSSIBLE THAT SOMEONE IS DOING SOMETHING NASTY! Someone could be eavesdropping on you right now (man-in-the-middle attack)! It is also possible that the RSA host key has just been changed. The fingerprint for the RSA key sent by the remote host is XX:XX:XX:XX:XX:XX:XX:XX:XX:XX:XX:XX:XX:XX:XX:XX. Please contact your system administrator. Add correct host key in /home/ユーザ/.ssh/known_hosts to get rid of this message. Offending key in /home/ユーザ/.ssh/known_hosts:NN RSA host key for ホスト名 has changed and you have requested strict checking. Host key verification failed. $などと表示されて接続できなくなってしまう。

画面に表示された通り known_hosts ファイルの該当行を削除すれば 再度接続できるのだが、 これを自動で行うためのスクリプトを作成してみた。

1#!/bin/sh 2cat << EOF | ex -s ${HOME}/.ssh/known_hosts 3`ssh $* 2>&1 | sed -n '/^Offending key/s/.*:\(.*\)/\1/p' | tr -d '\r'`d 4wq 5EOFPATH の通ったディレクトリに sshfix の様な名前で保存し 実行権限を付与しておくと、 ssh で接続を試みて上記エラーが発生した際に実行する事で known_host の該当行を削除するので再度接続できる様になる。

$ ssh ホスト名 @@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@ @ WARNING: REMOTE HOST IDENTIFICATION HAS CHANGED! @ @@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@@ IT IS POSSIBLE THAT SOMEONE IS DOING SOMETHING NASTY!</i> : $ sshfix !$ $ ssh !$くれぐれも本当に正しい接続先か確認してから利用しなければならない。

2011/02/12

シェルスクリプト自身のパス取得

シェルスクリプトを作成していて、

たまにスクリプト自身のパスを取得したい場合がある。

以下の処理でシェルの種類に依存せず(とは言っても bourne shell 系のみだが)

シェルスクリプト自身のパスを取得する事ができる筈(多分)。

PATH 環境変数に従って実行された場合は

${0} にスクリプトの絶対パスが格納されているので

${0} の dirname (1) を取得すれば良いが、

相対パス指定で実行された場合は 1度 cd (1) した上で

pwd (1) を実行してカレントディレクトリを取得する必要がある。

すべてのケースで

"( cd ${0%/*} `dirname ${0}` && pwd )"

しても同じ結果を得られるのだが、

サブシェルの実行や特に pwd (1) の実行はシステムに負荷をかけるので、

効率を考え ${0} の値を確認している。

expr (1) の実行も結構負荷がかかるからあまり意味ないかな…

1#!/bin/sh 2# ${0} の dirname を取得 3# cwd=${0%/*} 4cwd=`dirname ${0}` 5 6# ${0} が 相対パスの場合は cd して pwd を取得 7expr ${0} : "/.*" > /dev/null || cwd=`(cd ${cwd} && pwd)` 8 :

2011/03/17 追記

$ sh fooこの様に実行された場合 ${0} には foo が 格納されているので ${0%/*} では foo に展開されてしまい cd (1) がエラーとなる問題があったので、 dirname (1) を利用する様修正しました。